کوالکام با AI200 و AI250 به جنگ انویدیا میرود

نبرد کارایی: کوالکام با تراشههای Hexagon و استراتژی Inference، قصد دارد بازار مراکز داده را قبضه کند

از موبایل تا مرکز داده

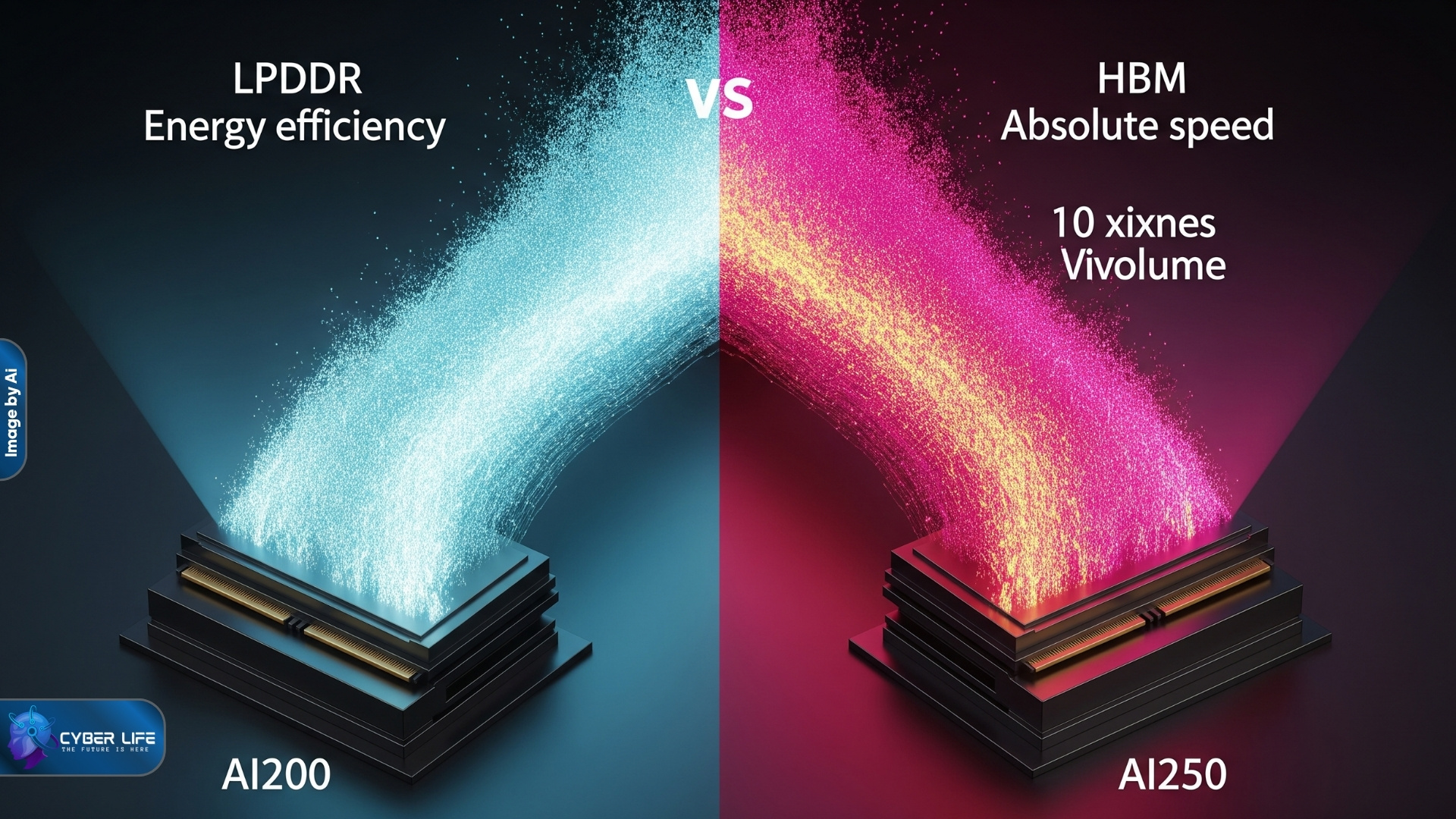

چگونه کوالکام با دو تراشه AI200 و AI250، یکی با LPDDR برای بهرهوری و دیگری با HBM برای پرفورمنس، استراتژی خود را در هوش مصنوعی تعریف کرد

در دنیای پرشتاب هوش مصنوعی، رقابت برای ارائه سختافزارهای قدرتمند و کارآمدتر که بتوانند نیاز روزافزون مراکز داده را پاسخ دهند، به اوج خود رسیده است. شرکت کوالکام تکنولوژیز (Qualcomm Technologies Inc.) به تازگی با معرفی دو تراشه هوش مصنوعی جدید خود که برای استفاده در مراکز داده طراحی شدهاند، یعنی AI200 و AI250، گام مهمی در این مسیر برداشته است. این خبر در زمان انتشار، چنان تأثیر مثبتی بر بازار گذاشت که سهام شرکت کوالکام در مقطعی بیش از ۱۵٪ و در نهایت حدود ۱۱٪ رشد کرد. این تراشهها قرار است به صورت کارتهای شتابدهندهای عرضه شوند که قابلیت اتصال به سرورها را دارند

سایبرکست قسمت 68: کوالکام با AI200 و AI250 به جنگ انویدیا میرود

کوالکام با دو تراشه جدید (AI200 و AI250)

AI250 با پهنای باند حافظه ۱۰ برابری نسبت به AI200، نشاندهنده تمایز استراتژیک کوالکام در پوشش نیازهای متنوع بازار است

رویکرد اصلی کوالکام در طراحی این پردازندهها، تمرکز بر موارد استفاده استنتاجی (Inference use cases) است، جایی که کارایی هزینهای اهمیت بالایی دارد. هدف این شرکت ارائه “عملکرد بالا به ازای هر دلار در هر وات” است. این تراشههای جدید بر پایه معماری Hexagon توسعه یافتهاند. معماری هگزاگون زیربنای واحدهای پردازش عصبی (NPU) است که کوالکام در سامانههای روی تراشه مصرفکننده خود نیز از آنها بهره میبرد. به عنوان مثال، یک واحد NPU مبتنی بر هگزاگون در پردازنده پرچمدار گوشیهای هوشمند این شرکت، یعنی Snapdragon 8 Elite Gen 5، استفاده شده است. با این حال، انتظار میرود که تراشههای جدید AI200 و AI250 کوالکام که برای مراکز داده طراحی شدهاند، تعداد هستههای به مراتب بالاتری نسبت به NPUs مصرفکننده داشته باشند.

معماری و حافظه در تراشههای جدید

تراشه AI200 که سطح پایینتری در میان تراشههای هوش مصنوعی جدید کوالکام دارد، مجهز به ۷۶۸ گیگابایت حافظه LPDDR است. حافظه LPDDR نوعی از رم است که به طور عمده در دستگاههای موبایل استفاده میشود و در مقایسه با حافظه DDR5 که معمولاً در سرورها به کار میرود، مصرف انرژی کمتری دارد. با این حال، حافظه LPDDR معمولاً پهنای باند حافظه کمتری نیز ارائه میدهد. پهنای باند حافظه، که سرعت انتقال داده بین هستههای تراشه و رم متصل را تعیین میکند، عاملی است که تأثیر بسزایی بر سرعت استنتاج مدلهای هوش مصنوعی دارد.

در نقطه مقابل، تراشه AI250 طراحی شده است تا بیش از ۱۰ برابر پهنای باند حافظه بیشتر نسبت به AI200 ارائه دهد. این افزایش چشمگیر در سرعت، احتمالاً به دلیل جایگزینی حافظه LPDDR با یک نوع رم پرفورمنستر است که سرعت بیشتری دارد. یکی از گزینههای محتمل برای دستیابی به این سرعت، استفاده از حافظه HBM (High Bandwidth Memory) است که در حال حاضر به طور گستردهای در پردازندههای هوش مصنوعی مراکز داده استفاده میشود. این تفاوت در پهنای باند حافظه نشاندهنده تلاش کوالکام برای پوشش دادن نیازهای مختلف مراکز داده، از کاربردهای متمرکز بر بهرهوری انرژی تا کاربردهای متمرکز بر سرعت مطلق، است.

قابلیتهای پیشرفته و استراتژی استقرار

کوالکام یک ویژگی امنیتی حیاتی را در هر دو تراشه AI200 و AI250 گنجانده است: محاسبات محرمانه (confidential computing). این فناوری با تقسیم حافظه تراشه هوش مصنوعی به چندین بخش رمزگذاری شده کار میکند. نکته مهم این است که تنها برنامهای که از یک بخش حافظه خاص استفاده میکند، میتواند محتویات آن را بخواند. این سطح از امنیت، برای حفاظت از مدلها و دادههای حساس در محیطهای ابری بسیار حیاتی است و مشابه این تکنولوژی توسط تراشههای رقیب مانند Blackwell Ultra انویدیا نیز پشتیبانی میشود.

کوالکام قصد دارد این تراشههای هوش مصنوعی را به عنوان بخشی از رکهای محاسباتی با خنککنندگی آبی (water-cooled compute racks) به بازار عرضه کند. این دستگاهها از PCIe برای اتصال اجزای داخلی و از اترنت برای فراهم کردن اتصال بین سیستمها استفاده میکنند. این شرکت همچنین در حال توسعه واحدهای پردازش مرکزی (CPUs) در سطح سرور است و این احتمال وجود دارد که رکهای محاسباتی جدید، شامل پردازندههای مرکزی سرور-گرید کوالکام برای مدیریت وظایف محاسباتی عمومی مانند اجرای سیستمعامل باشند. این استراتژی شبیه به کاری است که انویدیا با دستگاههای DGX AI خود انجام میدهد، که شامل پردازندههای مرکزی توسعهیافته داخلی هستند.

زمانبندی عرضه به بازار

کوالکام برنامهریزی کرده است تا تراشه AI200 را در سال ۲۰۲۶ و تراشه پیشرفتهتر AI250 را در سال ۲۰۲۷ عرضه کند. این شرکت در نظر دارد که خط تولید پردازندههای هوش مصنوعی خود برای مراکز داده را به صورت سالانه به روز رسانی نماید. این تعهد به بهروزرسانی سالانه نشاندهنده یک برنامه بلندمدت و جدی برای رقابت در فضای پرحرارت محاسبات هوش مصنوعی در سطح مراکز داده است.

همانطور که یک راننده مسابقات اتومبیلرانی، بسته به نوع پیست، بین دو لاستیک متفاوت یکی را انتخاب میکند—یکی برای دوام و مصرف کمتر سوخت و دیگری برای حداکثر سرعت در پیچهای تند—کوالکام نیز دو تراشه AI200 و AI250 را عرضه کرده است. AI200 با حافظه LPDDR، شبیه به لاستیک با دوام برای مسیرهای طولانی است که هدفش بهرهوری انرژی و هزینه است، در حالی که AI250 با پهنای باند حافظه ۱۰ برابری (شاید HBM)، حکم لاستیک مسابقهای را دارد که برای دستیابی به حداکثر سرعت و عملکرد در محاسبات استنتاجی سنگین طراحی شده است.

• جمعبندی :

همانطور که یک راننده مسابقات اتومبیلرانی، بسته به نوع پیست، بین دو لاستیک متفاوت یکی را انتخاب میکند—یکی برای دوام و مصرف کمتر سوخت و دیگری برای حداکثر سرعت در پیچهای تند—کوالکام نیز دو تراشه AI200 و AI250 را عرضه کرده است. AI200 با حافظه LPDDR، شبیه به لاستیک با دوام برای مسیرهای طولانی است که هدفش بهرهوری انرژی و هزینه است، در حالی که AI250 با پهنای باند حافظه ۱۰ برابری (شاید HBM)، حکم لاستیک مسابقهای را دارد که برای دستیابی به حداکثر سرعت و عملکرد در محاسبات استنتاجی سنگین طراحی شده است.

———————————————————————————

• نکات کلیدی:

-

محصولات جدید: دو تراشه هوش مصنوعی AI200 و AI250 برای مراکز داده.

- هدف اصلی: تمرکز بر استنتاج (Inference) و کارایی هزینهای با شعار “عملکرد بالا به ازای هر دلار در هر وات”.

- معماری: مبتنی بر معماری Hexagon (زیربنای NPUهای موبایل کوالکام).

- تمایز کلیدی (حافظه): AI200 از LPDDR (کممصرف) و AI250 احتمالاً از HBM (پرفورمنس بالا با پهنای باند ۱۰ برابری) استفاده میکند.

- امنیت: پشتیبانی از محاسبات محرمانه (Confidential Computing) برای حفاظت از دادههای حساس.

- استراتژی استقرار: عرضه به صورت رکهای محاسباتی خنکشده با آب که احتمالاً شامل CPUهای سرور-گرید داخلی کوالکام نیز میشوند.

-

زمانبندی: AI200 در ۲۰۲۶ و AI250 در ۲۰۲۷؛ تعهد به بهروزرسانی سالانه.

• نکات تکمیلی:

- خبر معرفی این تراشهها باعث رشد ۱۱٪ سهام کوالکام شد.

- این استراتژی کوالکام را قادر میسازد تا هم به بازار متمرکز بر بهرهوری انرژی و هم به بازار متمرکز بر سرعت مطلق پاسخ دهد.

- رویکرد جامع (تراشه شتابدهنده، CPU سرور، رک محاسباتی) شبیه به استراتژی انویدیا در DGX AI است.

• نتیجه گیری

ورود کوالکام با تراشههای AI200 و AI250 نشاندهنده بلوغ بازار هوش مصنوعی استنتاجی است که دیگر تنها بر سرعت مطلق متمرکز نیست. استراتژی “دو محصولی” کوالکام که یکی را بر بهرهوری انرژی (LPDDR) و دیگری را بر عملکرد بالا (HBM احتمالی) متمرکز کرده، یک اقدام هوشمندانه برای تصاحب سهم بازار در بخشهای مختلف مراکز داده است. با توجه به سابقه کوالکام در کارایی انرژی در دنیای موبایل، این شرکت میتواند چالشی جدی برای حاکمیت انویدیا ایجاد کند، به ویژه اگر بتواند وعده “عملکرد بالا به ازای هر دلار در هر وات” را محقق سازد. تعهد به ارائه یک راهحل جامع سختافزاری و بهروزرسانی سالانه، نشاندهنده یک رقابت طولانیمدت و جدی است.

• پرسشهای تحقیقاتی بیشتر:

-

قیمت نهایی رکهای محاسباتی کوالکام در مقایسه با DGXهای انویدیا چقدر خواهد بود و آیا اختلاف قیمت، مزیت کارایی هزینهای را تقویت میکند؟

- عملکرد واقعی تراشههای مبتنی بر معماری Hexagon کوالکام در مقابل هستههای CUDA انویدیا در اجرای مدلهای بزرگ زبان (LLMs) در فاز استنتاج چگونه است؟

- آیا کوالکام میتواند به سرعت یک اکوسیستم نرمافزاری و توسعهدهنده قوی مانند CUDA برای جذب مشتریان مراکز داده ایجاد کند؟

-

رویکرد دوگانه حافظه (LPDDR vs HBM) تا چه حد بر انتخاب مشتریان تأثیر خواهد گذاشت و کدام تراشه سهم بیشتری از فروش را به دست خواهد آورد؟

• سخن پایانی نویسنده :

این خبر یک سیگنال بزرگ به بازار میدهد: انحصار در حال شکستن است. کوالکام با سابقه درخشان در بهرهوری انرژی، این بار با یک استراتژی هوشمندانه وارد بازی مراکز داده شده است. انتخاب بین AI200 (کارایی) و AI250 (سرعت) مانند انتخاب بین یک خودروی هیبریدی اقتصادی و یک خودروی مسابقهای است؛ هر دو مشتریان خود را دارند. تمرکز بر استنتاج یک حرکت درست است، چرا که ۸۰٪ بار محاسباتی در آینده مراکز داده، استنتاج خواهد بود. اگر کوالکام بتواند قیمت و کارایی را به درستی تنظیم کند، رقیب اصلی انویدیا، نه فقط در اسم، بلکه در عمل خواهد بود.

منبع : به گزارش siliconangle